2024年11月にカバー株式会社は、Unreal Engineを活用した新しいバーチャルライブ開発プロジェクトの始動を発表。プロジェクト成果第一弾として、ReGLOSSデビュー1.5周年を記念して2025年3月に開催した『ReGLOSS 3D LIVE「Sakura Mirage」』にて、Unreal Engineを使った初の音楽ライブ配信を実現しました。

Unreal Engineは、アメリカのEpic Gamesが開発し、1998年、リアルタイム3Dコンテンツ制作のため初めて商用タイトルで採用されたゲームエンジンです。高品質なグラフィックス表現やリアルタイムレンダリング、豊富なアセットの提供など、開発を支援する多くの機能を備えていることが特徴で、近年ではゲームエンジンとしてだけでなく、映像制作、建築・製造、シミュレーション、教育など、さまざまな分野へと用途が広がっています。ライブ演出やメタバースなどにも応用されるようになり、国内外の様々なプロジェクトで活用が進んでいます。

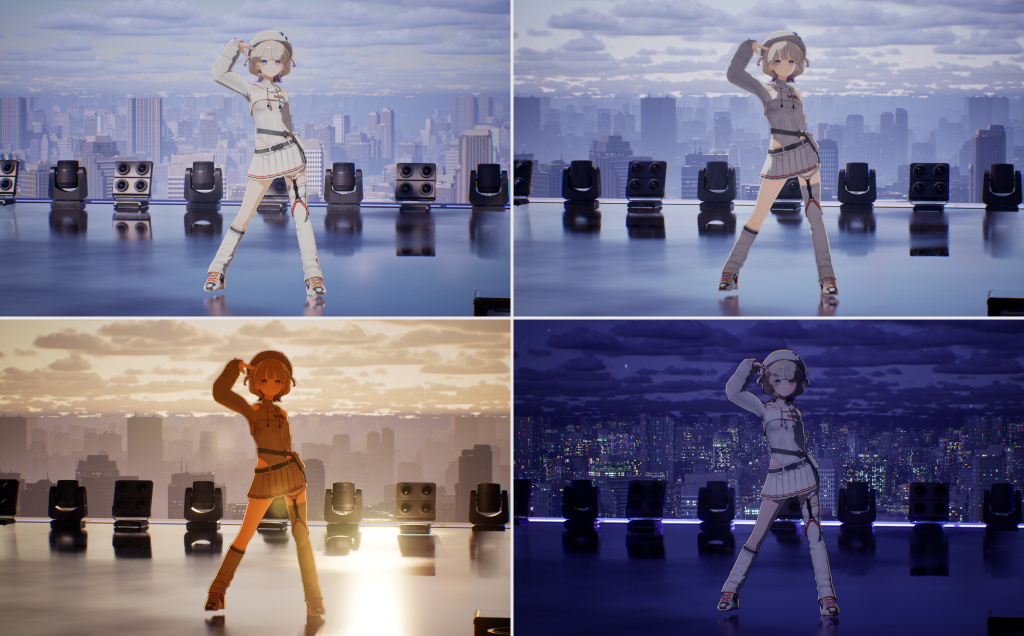

今回、カバー初となるUnreal Engineを活用した音楽ライブ配信では、実際のアーティストによる音楽ライブなどと同様に「カメラの露出」や「時間帯による演出変化」といった細かな要素にもリアルタイムで対応し、没入感と実在感のあるライブ空間が構築されました。

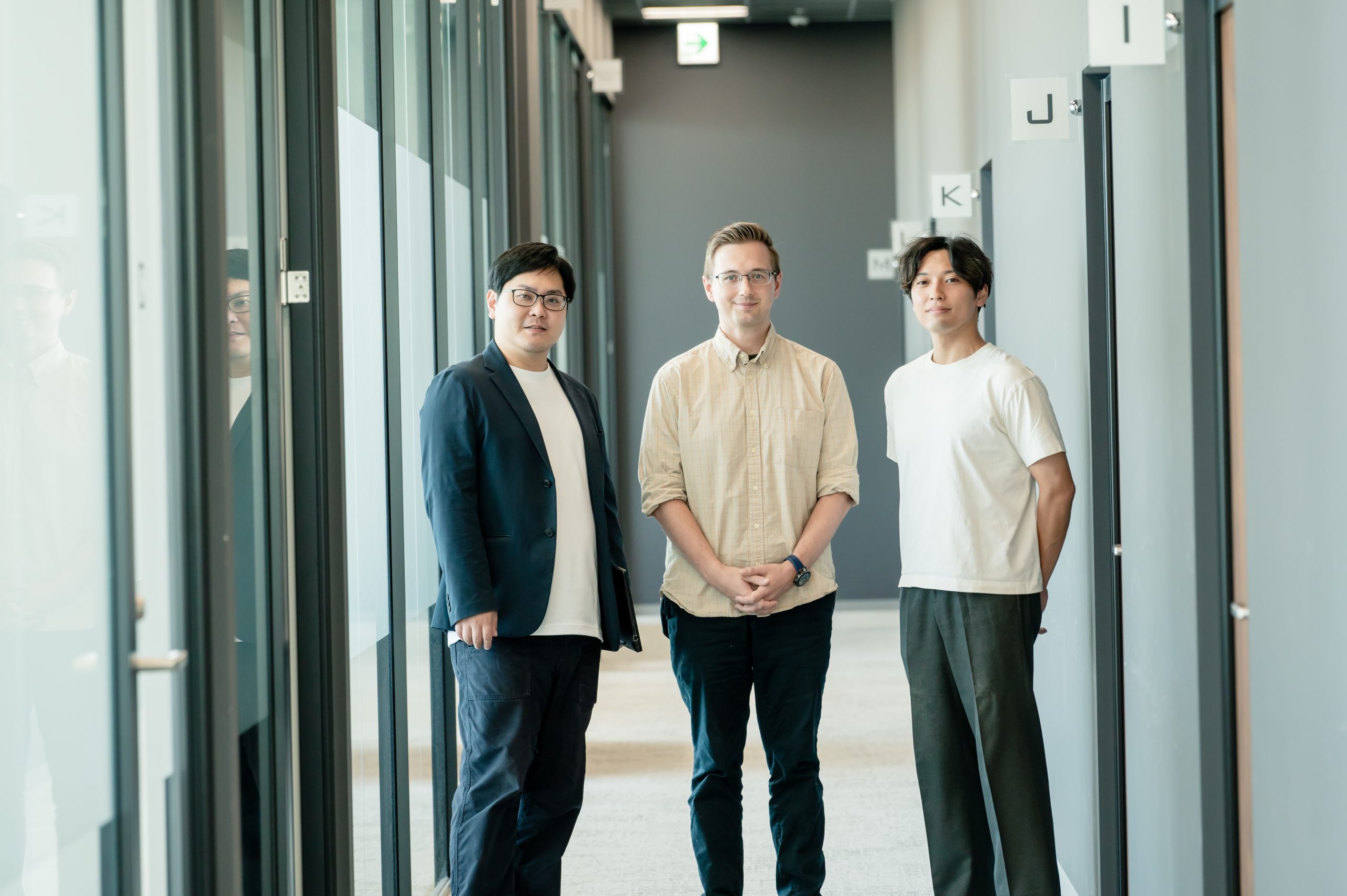

今回、COVERedge(カバレッジ)では、制作に携わったカバー クリエイティブ事業本部の技術開発部メンバーと、Epic Games Japanによる座談会を通じて、VTuberによる音楽ライブ配信の表現に革新をもたらした技術の裏側に迫ります。

Epic Games Japan

代表 河崎 高之

カスタマーサクセス ディレクター 篠山 範明

カバー株式会社

- 取締役CTO 福田 一行

- クリエイティブ制作本部 技術開発部 アートエンジニアリングチーム 奥川 剛(マネジャー/グラフィックスエンジニア)

- クリエイティブ制作本部 技術開発部 第三開発チーム 平野 晶麗(リードエンジニア)

- クリエイティブ制作本部 技術開発部 UE開発チーム 伊藤 彪悟(3Dデザイナー)

- 株式会社SPARK 広本 則行(グラフィックスエンジニア)

「実在感の追求とタレントの期待に応える」VTuberのライブ配信技術の進化とUnreal Engineの導入効果

先日、Unreal Engineを活用したReGLOSSの1.5周年ライブを拝見しました。非常にクオリティが高く、大変感動しました。このライブ配信にUnreal Engineを導入するに至った経緯と、これまでのライブ配信の技術的進化について教えてください。

ありがとうございます。ホロライブプロダクションの音楽配信ライブは、VR機材をモーションキャプチャーとして活用するところからスタートしました。当時は機材や場所の制約も多く、長時間の配信が技術的に難しかったですね。グラフィックに関しては、革新的に一気に進化したというよりも、積み重ねで少しずつ改善してきています。特筆すべきは、技術の進化だけではなく、ライティング(照明)やカメラワークなど、現場で操作するメンバーのスキルや制作するスタッフの熟練度も高まってきたことで大きく進化してきた側面も大きい点ですね。

そうした進化を続けていく中でも、「実在感」や「没入感」を演出し、リアルな音楽ライブが持つ情報量をバーチャル空間に落とし込むにはまだまだ技術が足りていないと感じていました。そうした課題を抱える中、Unreal Engineが発表したUE5のマトリックスのデモを見た際に、圧倒的な情報量に衝撃を受け「これを使ってライブ配信をやりたい」と強く思いました。現在は個人のクリエイターでもUnreal Engineを使って高品質なコンテンツを作れます。こうした背景からも、企業としても早急にUnreal Engineを活用したライブ配信を提供する必要があると考え、今回急ピッチで導入に踏み切りました。

Unreal Engineを活用したライブ配信への、ファンやタレントからの反応はいかがでしたか?

Unreal Engineの導入に当たっては、タレントさんたちの思い描く演出や表現を実現したい、という「タレントサポート」という側面も大きかったのですが、制作過程でタレントさんにも随時見てもらう中でも、「今までできなかったことができるかも」という期待感が高まったように感じます。実際に他のタレントさんからも「Unreal Engineを活用したライブ配信をやりたい」という声を多数いただいています。期待に応えられる環境が整ったことは大きな意義があると感じています。

ファンの方には、より驚きを与えるという点でも、高品質なグラフィック表現は非常に効果的でした。実はファンの間でもグラフィックへの期待感が高まっていて、「Unreal Engineを使うとさらにこんなことができるのでは」というディスカッションがSNSなどでも活発にされていたんです。ファンの反応で特に印象的だったのは、技術的な細部にまで気づいてコメントしてくれる点ですね。例えば「スケルタルメッシュを使った水の表現がすごい」など、かなり専門的な観点からもフィードバックをいただいたりと、こちらも励みになりました。

社内でも技術ショーケースとして、エンジニア以外のスタッフにUnreal Engineのライブ環境を体験してもらう機会を設けたんですが、技術に詳しくないスタッフも含め、多くの方が興味を持って参加してくれたのも嬉しかったですね。

カバーでは音楽ライブ配信に活用しましたが、Unreal Engineはもともとゲーム開発向けのエンジンです。現在、日本国内ではどのような分野で活用されているのでしょうか?

日本では特にテレビ局での活用が進んでいますね。定期的に番組やドラマを制作する現場で、Unreal Engineの効率性とスピード感が高く評価されています。例えば、NHKの大河ドラマや民放各局のドラマ制作でLEDウォールを使った撮影や、バーチャルスタジオでのVFX制作など様々な場面で使われています。最近では、スタイライズ(※1)されたトゥーンシェード(※2)などがアニメ制作現場でも多く使われるようになってきました。映像・放送分野ではかなりの作品数でご利用いただいている状況です。

※1 オブジェクトやデザインを独自のスタイルで表現したり、キャラクターを特定のスタイルに統一したりすること

※2 3DCGを手描きのイラストやセル画調のアニメーションのように見せる技術、手法のこと

テレビやその他の映像制作現場では、締め切りがシビアで、従来はイテレーション(※3)の回数が限られていました。それがリアルタイムレンダリングによって、すぐに結果を確認できることで、よりクオリティの高い作品が効率的に作れるようになってきています。これまでにも映像業界では専用ソフトウェアやミドルウェアが使われてきましたが、Unreal Engineの最大の利点は、高品質なビジュアルをリアルタイムで制作できる環境が整っていることですね。また、Unreal Engineだけでなく、Megascans(※4)などのアセットも含め、Epic Games全体のエコシステムとして少人数でも高品質のコンテンツを制作できる環境を提供しています。

※3 ソフトウェア開発やプロジェクト管理において、設計、開発、テストを短期間で繰り返し実行する開発サイクルのこと

※4 Quixel社の撮影チームが提供する、光学現象を忠実に再現する物理レンダリングに対応した高品質な3Dデータライブラリーのこと。このデータはUnreal Engineにエクスポートすることができる。

特に映像制作やアニメ制作の現場では従来の工程を大幅に効率化できます。極端な話、絵コンテなしで、ディレクターや監督がエディタ上で直接組み上げることも可能なんです。使い手側がリアルなパイプラインに近づくことで、トライアンドエラーのスピードが格段に向上する点を高く評価いただいています。

「フォトリアルとアニメの共存を目指して」エンジニアが挑んだUnreal Engine活用の革新的アプローチ

今回カバーさんは初めてUnreal Engineを導入されましたが、音楽ライブ配信に導入することによって、技術的に苦労した点や工夫した点をお聞かせください。

今回、私は開発ディレクションを担当しましたが、 Unreal Engineの導入で最も恩恵を受けたのはライティングの品質と制作スピードでした。会場のライティング設計が数週間というスピード感で完成し、表現力も期待を大きく上回る完成度となりました。一方で、Unreal Engineが得意とする現実感のあるフォトリアルな表現と、ホロライブのアニメ調のタレントさんを一つの空間で自然に共存させるためには、多くの技術的工夫が必要でした。

私はグラフィックを担当していますが、映像として見栄えの良い「実在感」と「アニメ調」のバランスを取るのに一番苦戦しましたね。中でもタレントさんと背景の融合には特に力を入れており、「ホロカラーグレーディング」という仕組みを実装し、Unreal Engineの標準ポストエフェクトとは異なる独自のポストエフェクトボリュームを作成しました。これにより、タレントさんと背景を別々にグレーディング(※5)し、その後にマスターグレーディングをかける仕組みを導入できました。さらに、時間変化や天候変化といった要素のパラメーターでも人物と背景を別々に色調整することを可能にし、リアルな背景とスタイライズされたタレントさんを自然に馴染ませることもできました。

※5 映像の色調、トーン、階調を調整し、特定の雰囲気や世界観を演出する映像加工処理のこと

また、Unreal Engineの照明技術であるルーメンも工夫したんです。デフォルトのルーメンを使うとタレントさんが立体的になりすぎてフィギュアのように見えてしまうため、立体感を抑えつつも環境光はしっかりと入れるよう調整しました。

私の方ではキャラクターのシェーダー開発やポストエフェクトの実装などを含むエンジン改造で開発協力をさせてもらいました。具体的には既存のキャラクター表現をどうUnreal Engineに落とし込むかという部分で、これはエンジン改造なしには対応できませんでした。表現の幅広さに対して、Unreal EngineのGバッファ(G-Buffer)(※6) 容量が足りないため、データを量子化して圧縮したり、マテリアルごとにコンスタントバッファーを追加出来るように拡張するなどの対策を行いました。

また、多数のライトが同時に当たる環境では、標準的なライティング処理ではセルルックのタレントさんの見た目が破綻してしまうため、タレント用に独自のライティングを実装しました。これにより、50個以上のリアルタイムライトが存在する環境でもアニメ調の一貫性を保ったシェーダー表現が可能になりました。

半透明処理に関しても対象のマテリアルだけ別バッファでマルチパスレンダリングを行い合成することで半透明のマテリアルをディファードでライティングできるようにもしています。

※6 Gバッファにはオブジェクトの幾何学的情報(法線情報やアルベド(表面の色)情報、深度情報など)が格納されている。Gバッファを使用することで、レンダリングのパフォーマンスを向上させ、より複雑なライティング処理を行うことができる。

▼50個以上のリアルタイムライトを使った表現

私はタレント周りの開発を担当しています。タレント表現におけるアウトラインの処理に工夫を凝らしました。

対策として、プッシュアウトラインとポストアウトラインの2種類を使い分け、カメラの距離によって適切に切り替わるよう細かく調整しました。また、ライブ中は時間経過に合わせて夕日から夜へと演出が変化するため、タレントさんたちの動きもこうした変化に自然に馴染むよう、カラーグレーディングをシーケンサー(※7)で時間帯ごとに調整し、リアルタイムで反映されるように設定しました。法線周りについても、当初はSDFテクスチャーを使って陰影を制御していましたが、複数のライトがある環境では相性が悪く、望ましくない見た目になってしまったため、SDFテクスチャー(※8)を使わず、頂点法線による制御に切り替え、美しい影が入るよう改善しました。

※7 カットシーンを作成するためのエディター。タイムライン上にカメラ、キャラクターなどを配置して、一連のシーンを作成することができる。

※8 SDF(Signed Distance Field)用いて3D形状を表現するテクスチャの一種。オブジェクトの位置から形状までの距離を格納することで形状の境界をとても滑らかに表現でき、拡大縮小やアニメーションに強いテクスチャ表現が可能になる

SDFテクスチャーは1つのライトに対しては効果的ですが、複数のライトが当たると意図しない帯が発生してしまいます。例えば、タレントさんに対して右から当てたライトと左から当てたライトのSDFテクスチャーが重なると、2D的な不自然な帯が発生し、意図しないアニメっぽさが出てしまうんです。そのため、アニメライクなキャラクターが登場する格闘ゲームなどで使われているような頂点法線の編集による手法に回帰することになりました。この技術的な回帰が、複数光源環境では理にかなった選択だったと思います。

あとは、実際の音楽ライブと同じように「カメラの露出」という問題も発生しましたね。本物のライブカメラと同様のスポットライトを当てると明るくなりすぎたり、露出調整によってタレントさんが暗くなりすぎる問題が起きてしまったんです。

そうした問題に対応するため、MIDIコントローラーを使ってカメラごとに露出の補正を行う仕組みを導入しました。アウトラインについても、ライブカメラでは200mmや300mmといった望遠レンズの設定を使うので、そうした画角に合わせたアウトラインの押し出し計算も実装する必要がありました。

カメラではLive Linkプラグイン(※9)も活用していますが、今回FreeDプロトコル(※10)を使い、パナソニックのカメラリモートコントローラーと連携させ、実際の放送機材と同じような感覚でバーチャルカメラを操作できるようにしています。テレビ現場の知識を持つスタッフがいたおかげで、実際の放送現場と同じようなワークフローを構築できました。そのスタッフからは「Unreal Engineを使っているけれど、やっていることは現実の撮影現場と変わらない」という反応をもらったのですが、テレビ業界出身のスタッフの技術とUnreal Engineが融合した好例だと思います。

※9 外部のソフトウェアやデバイスからリアルタイムでデータをUnreal Engineにストリーミングするための、Unreal Engineのプラグイン。アニメーションデータやカメラの動きなど、リアルタイムで情報を共有するための基盤を提供している。

※10 カメラの動きをCGコンテンツと連携させるために、カメラの位置情報(パン、チルト、ズーム等)を送信する制作システムに直接送信するための通信規格。

実際にUnrealEngineで開発してみて、ライブ配信のコンセプトやタレントさんの要望を実現する力が非常に高いと感じています。天候変化や時間経過など、当初のコンセプトをそのまま実現でき、その品質も非常に高いものになりました。特に、ライティングの施策によって、非常に実在感が高まったライブ配信になりましたし、雨が降るとタレントさんの体から水が弾けたり、顔に雨が流れたりといったインタラクティブな表現も、実在感の向上に大きく貢献しました。

フォトリアルに最適化されたシステムを、アニメライクに仕上げていくために様々な調整が行われていたのですね。加えて、ライブ配信ではフレームレートや遅延への対策も極めて重要だと思いますが、今回はどのような最適化を行いましたか?

最大のネックは、レイトレーシング(※11)を有効にした上で50個以上のライトを使用している点でした。そこでまず、影を当てるライトと当てないライト、ライティングを行うライトなど、チャンネルの管理を徹底しました。また、半透明のライトボリュームが多数重なると負荷が高くなるため、Variable Rate Shading(VRS)(※12)を活用し、最適化を行いました。本来なら適応的に処理されるVRSも使いたかったのですが、時間の制約があったため定数単位での設定としました。にもかかわらず、2〜3倍の速度向上が得られました。

DMX(※13)のライトシャフトの計算も大幅にカスタマイズし、レイマーチング(※14)のステップ数を減らすなどの対策を実施しました。さらにパッケージングの最適化も行いました。依存関係を減らすことで、これまで1時間ほどかかっていたパッケージング処理が、差分更新であれば5〜10分程度で完了するようになり、イテレーションの速度向上は開発効率の面でも非常に重要でした。

※11 光から発せられる光の量や角度、屈折、反射などをコンピューターでシミュレーションすることで、リアルな映像を生成するレンダリング技術の一種。光の反射、屈折、影などを正確に表現するために使われる

※12 Variable Rate Shading (VRS、可変レートシェーディング)はゲーム開発におけるパフォーマンス、画質向上するためのレンダリング技術の一種。描画処理の負荷を軽減するために、ピクセルのシェーディングレート(1ピクセルあたりを処理する頻度)を動的に調整することができる。

※13 DMX(Digital Multiplex)は、ライブ、イベントでステージのライティングやエフェクトを単純なものから複雑なものまでコントロールするために使用されるデジタル通信ネットワーク

※14 レイトレーシング分野におけるレンダリング技法の一種。

エンジン内部のカスタマイズも多く行いました。Gバッファの節約のために値を4ビットなどに圧縮したり、チャンネルに複数のパラメーターを詰め込んだりしています。また、半透明処理のためにディファードレンダリング(遅延シェーディング)(※15)を拡張し、ステンシルマスクを活用した高速化も実装しました。シェーダー内の分岐処理の最適化も地道に行っています。

CPU側の最適化も重要でしたね。特にDMXプラグインのブループリント処理をC++化することで、エディタ実行中のパフォーマンスを大幅に改善しました。将来的には、エディタ上でのリアルタイム編集とライブ配信での使用を両立させるため、さらなる最適化を進めていきたいと考えています。モーションキャプチャーについては、カバー独自のシステムを使用しています。Vicon(※16)からMotion Builder(※17)へのプラグイン、そしてそこからUnreal Engineへのデータ連携も独自のものを開発しました。

Live Linkでもモーションキャプチャーを取り込むことは可能なのですが、カバーではUnreal EngineとUnity(※18)の両方で開発を行っているので、マルチエンジン対応が必要でした。また、生放送で絶対に事故が起こせないため、冗長化対応や通信負荷の分散なども考慮した独自システムを開発しているんです。実際にライブ配信では15台ものレンダリングPCを使用しており、それに伴う通信負荷は非常に大きくなります。そのためマルチキャストを活用した通信の最適化も行っています。このような通信負荷を考慮した実装は、ライブ配信の安定性を確保する上で非常に重要です。

※15 3DCGのレンダリング手法の一種。リアルタイムで複雑な照明表現を効率的に行うことができる。

※16 モーションキャプチャシステムの名称

※17 リアルタイム 3D キャラクター アニメーション ソフトウェアの名称

※18 ユニティ・テクノロジーズ社が開発・提供するゲームエンジンのこと

なるほど、ありがとうございます。エンジニアではなく、実際のカメラマンや照明担当者の方がUnreal Engineを直接操作しているという事例は非常に興味深いですね。

従来は照明シミュレーションソフトで設計したものをゲームエンジンに移植する工程が必要でしたが、今回は照明の専門家が直接Unreal Engine上でフィクスチャー(※19)の設定やパッチング(※20)を行いました。ゲームエンジンをプロの照明担当者が使用するという新しい動きが生まれていることはとても革新的だと私たちも感じましたね。

※19 DMXプロトコルを使用して制御される照明器具のこと

※20 DMX照明制御において、コントローラー上で各照明機器のアドレスを設定し、適切に制御できるようにする作業のこと

「多様なスキルとサポート体制の重要性」Unreal Engine開発環境の強みと展望

Unreal Engineを導入したことで感じたメリットやコスト面、組織的な効果についてはどうでしたか?

制作から実装のスピードの早さはとても助かりました!Unreal Engineには高品質なアセットが揃っており、非エンジニアでも開発に参加できるので、音楽ライブのコンセプトからステージのプロトタイプの完成まで、数週間で完成しました。

今回の音楽ライブ制作では、7〜8ヶ月という期間の中で、必要な部分はエンジン改造を行いつつも、DMXプラグインなどUnreal Engineの既存機能も最大限に活用するという、バランスの良いアプローチを取ることができました。Unreal Engineは様々なシチュエーションに対応できる柔軟性が非常に優れていて、短期プロジェクトではエンジン改造なしでもクオリティの高いコンテンツをすぐに作れますし、大規模プロジェクトではソースコードを改変して自分たちの表現を追求することができるのが大きなメリットだと感じました。

今回の音楽ライブ制作の現場には、ゲーム業界、テレビ業界、モバイル業界と幅広い業界からカバーに来たスタッフが混在していましたが、彼らのスキルがうまくマッチし実現できたように思います。ところで、Epic Gamesさんが想定している、Unreal Engineを使う際に求められるスキルセットはどういったものでしょうか?

私はテクニカルサポートの立場から様々なお客様とやり取りしていますが、どの業界で活用するにしても、「リアルタイムレンダリング」という概念に精通していることは非常に重要だと思います。ゲーム業界では16ミリ秒という短時間でフレームを描画するために様々な工夫をしており、そうしたリアルタイムの制約の中で何ができるかを理解していることはUnreal Engineを活用する上でとても重要です。従来の映像業界などのオフラインレンダリングに慣れている方がいきなりUnreal Engineを使うと、様々な制約に驚くことがあります。奥川さんのようにゲーム業界のグラフィックスのプロフェッショナルがいることは、カバーさんにとって大きな強みだと思いますね。

もう一点、ライブ配信の現場では複数のUnreal Engineをインスタンス化し、同期させて動かすことが必要になります。Unreal Engineはネットワークレベルからモニターの同期まで様々なツールを内蔵していますが、問題発生時にどこに原因があるのかを理解できる知識も必要です。

やはり、ライブ配信の制作という側面では、エンジニアチームにゲーム業界から映像業界まで多種多様なスキルを持っている方が集結することが必要となりそうですね。Epic GamesさんではUnreal Engineの利用者向けにどのようなサポートを提供されているか詳しく伺いたいです。

「Epic Pro Support」という有償での公式サポートと、「Epic Developer Community」というユーザー同士のコミュニティフォーラムを通して助け合いや情報交換の促進を行っています。有償のサポートでは、高度な技術的課題や最新情報に対するサポートを提供しており、実際に私たちがオンサイトで行うプロファイリングや最適化のノウハウなども共有しております。私たちのチームでは主にコミュニティサポートを行っており、最近では、プロサポートのQ&Aを一般公開する取り組みも始めました。有償サポートで回答した内容を、秘匿情報を除いて「Epic Developer Community」に公開することで、より多くの開発者が高品質な情報にアクセスできるようにしています。

このQ&Aの情報公開についての取り組みは、Epic Gamesの創業者であるティム・スウィーニーの強い思いが背景にあります。ティム自身がパソコン1台でゲーム開発からキャリアをスタートさせた経験から、インディーゲーム開発者や学生など、これからクリエイターを目指す人々をサポートしたいという願いを持っており、クリエイターが成長できる環境づくりに力を入れています。

あとは、各地で熱心なUnreal Engineのファンが自主的にイベントを企画してくれることもあり、そうしたコミュニティイベントにEpic Gamesも積極的に参加しています。東京や大阪、福岡だけでなく、様々な地域にUnreal Engineの愛好家がいて、自分たちの周りを盛り上げようとするエネルギーがあります。そういった方々を大切にし、可能な限りサポートしていきたいと考えています。

「未来を創る技術の進化」カバーとEpicが描く、Unreal Engineが拓く表現とエンターテイメントの未来

Epic Gamesとしての今後の展望やUnreal Engineの発展方向について教えていただけますか?

Unreal Engineは現在、クオリティを上げる垂直方向の進化と、プラットフォームやユーザー層を広げる水平方向の進化という二つの軸で発展を構想しています。Epic Games全体としては、モバイルプラットフォームへの対応強化が大きなテーマとしてあり、より多くの端末で高品質なコンテンツを提供できるよう最適化を進めています。

また、メタバース構想も重要な戦略として掲げています。『フォートナイト(Fortnite)』を活用した世界規模の展開がその象徴的な取り組みであり、Unreal Engineはその技術的インフラとして機能しています。特に、「UEFN(Unreal Editor for Fortnite)」などを通じてUGC(ユーザー生成コンテンツ)にも注力しており、エンジニアだけでなく一般ユーザーもコンテンツ制作に参加できる環境づくりを進めています。

技術的な観点では、グラフィックスの向上に加えて、動きやモーションの表現がこれからの重要なテーマになると考えています。Epic Gamesではメタヒューマンというリアルな人間を作る包括的なサービスを提供していますが、最近ではメタヒューマンアニメーターという機能も加わりました。これはiPhoneで自分の表情を撮影するだけで、その動きをメタヒューマンに転写できるというものです。現在はリアルな人間を軸に開発していますが、今後は様々なタレントや表現に適用できるよう拡張していく予定です。リアルタイム性をさらに高めることで、より自然でインタラクティブな表現が可能になると期待しています。

また、最近では、ラスベガスの「Sphere(スフィア)」のような没入型ディスプレイでの活用にも注目しています。従来は事前にレンダリングした映像を投影するケースが多かったのですが、最近ではリアルタイムでUnreal Engineを使った投影も増えており、例えば、即興演奏で知られるバンド『Phish』のライブでは、その場の演奏に合わせてUnreal Engineによるグラフィックスを「Sphere」の球面スクリーンにリアルタイムで投影するプロジェクトがアメリカで実施されました。また、『フォートナイト』のイベントでは、ニューヨークのタイムズスクエアの複数の大型ディスプレイを同時制御し、アーティストのパフォーマンスと連動させるような施策も行われています。

こうしたイマーシブな体験におけるUnreal Engineの活用は、日本国内でも今後ますます広がっていくと考えています。今年の11月14日・15日には、東京・高輪で「Unreal Fest 2025 Tokyo」の開催が予定されています。今年は昨年よりも規模を拡大し、2日間にわたって様々な業界におけるUnreal Engineの最新活用事例や技術情報が共有される場となりますので、興味のある方はぜひ足を運んでみてください。

カバーさんは今後、Unreal Engineを活用して挑戦してみたいことはありますか?

ライブ配信のクオリティは今後もさらに高めていきたいと考えていますし、ライブ配信だけでなく、様々なイベントでの活用も考えています。例えば、ホロライブでは毎年夏に水着イベントを行っていますが、Unreal Engineを使えば海の中を泳ぐような演出も実現できるかもしれません。また、AR(拡張現実)のような実写との合成も今後増えていくと思います。リアルタイムライティングとの相性の良さを活かし、外ロケやテレビ番組への展開も視野に入れています。

さらに、ゲームエンジンとしての特性を活かし、ファンとのインタラクティブなやり取りができるコンテンツも検討しています。カバーではメタバース事業も展開しているので、映像配信のみならず、3D空間としてのコンテンツ開発にもUnreal Engineを活用していきたいと考えています。

今回の座談会を通じて、「実在感」と「アニメ表現」という一見相反する要素を融合させるため、多様な専門家が結集して挑む姿が見えました。タレントの想いを実現する「タレントサポート」とクリエイターを支援する技術開発という両社の共通点が、新しいVTuberエンターテインメントの可能性を広げています。これからも成長を続ける、Unreal Engeneを活用したカバーのエンターテインメントにご期待ください。

※UnrealおよびUnreal Engineは、アメリカ合衆国やその他の国々におけるEpic Games, Inc.の商標または登録商標です。

本記事に関連する採用情報は下記よりご確認ください

3DCGアートディレクター

3D背景デザイナー(Vtuber/ライブ制作)

3Dキャラモデラー(Vtuber/ライブ制作)

テクニカルアーティスト(Vtuber/ライブ制作)

【学生インターン歓迎】リアル3Dライブ_テクニカルスタッフ

採用情報はこちら【配信システム】

-

エキスパートUnityエンジニア(配信システム)

当社の主力事業である配信アプリシステムの技術的根幹を担い、将来を見据えたアーキテクチャ設計や技術的意思決定をリードするエキスパートエンジニアを募集します。 開発チーム全体の技術力を底上げし、高難易度の課題解決やイノベーションの創出を牽引していただく、極めて重要なポジションです。

詳細・応募はこちら

-

QAリーダー(VTuber配信事業)

VTuberのアセット(3D/Live2D)や、ライブを実現するためのシステム(Unity製の独自ツール)等の品質保証(Quality Assurance)の仕事です。 社内の開発チームと連携し、各種コンテンツのテストケースの作成とテスト運用を担っていただきます。 また、コスト最適化のための改善業務にも取り組んでいただきます。

詳細・応募はこちら